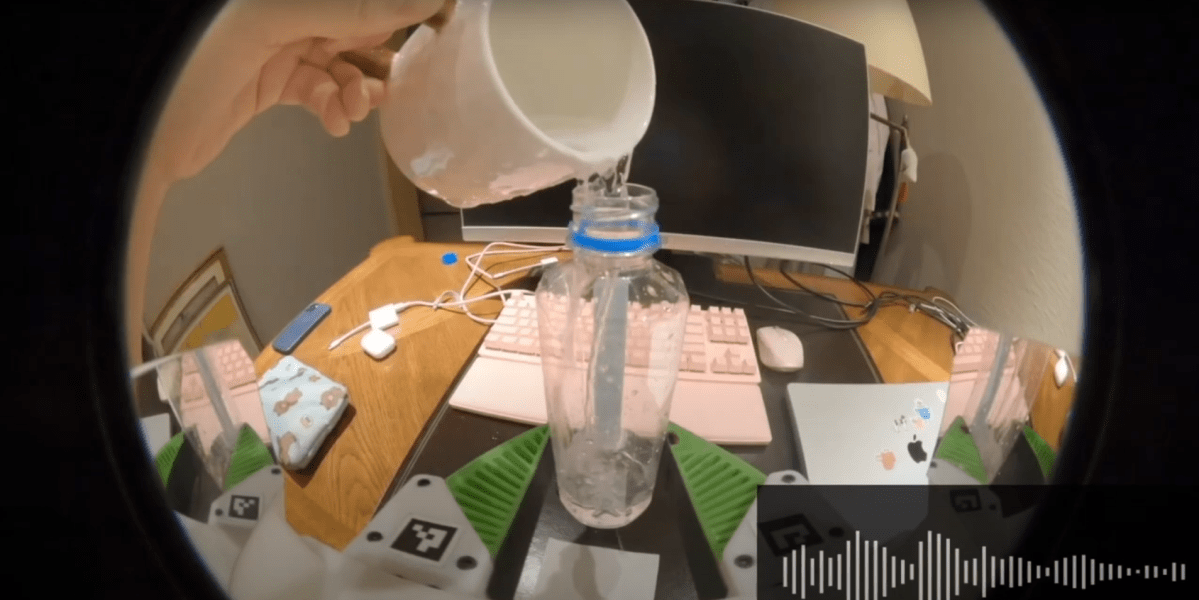

Los investigadores del Laboratorio de Robótica e Inteligencia Synthetic Corporizada de la Universidad de Stanford se propusieron cambiar eso. Primero construyeron un sistema para recopilar datos de audio, que consta de una pinza con un micrófono diseñado para filtrar el ruido de fondo y una cámara GoPro. Los demostradores humanos utilizaron la pinza para una variedad de tareas domésticas y luego utilizaron estos datos para entrenar brazos robóticos para que ejecutaran la tarea por sí solos. Los nuevos algoritmos de entrenamiento del equipo ayudan a los robots a recopilar pistas de las señales de audio para realizar un trabajo más eficaz.

“Hasta ahora, los robots se han estado entrenando con vídeos silenciados”, afirma Zeyi Liu, estudiante de doctorado en Stanford y autor principal del estudio. “Pero hay muchísimos datos útiles en el audio”.

Para comprobar cuánto más éxito puede tener un robot si es capaz de “escuchar”, los investigadores eligieron cuatro tareas: dar la vuelta a un bagel en una sartén, borrar una pizarra, unir dos tiras de velcro y sacar dados de un vaso. En cada tarea, los sonidos proporcionan pistas con las que las cámaras o los sensores táctiles tienen dificultades, como saber si el borrador está en contacto adecuado con la pizarra o si el vaso contiene dados o no.

Después de demostrar cada tarea un par de cientos de veces, el equipo comparó las tasas de éxito del entrenamiento con audio frente al entrenamiento solo con visión. Los resultados, publicados en un artículo en arXiv que no ha sido revisado por pares, fueron prometedores. Cuando se utilizó solo la visión en la prueba de los dados, el robotic solo pudo decir el 27% de las veces si había dados en el cubilete, pero ese porcentaje aumentó al 94% cuando se incluyó el sonido.

Liu afirma que no es la primera vez que se utiliza el audio para entrenar robots, pero es un gran paso para hacerlo a gran escala. “Estamos facilitando el uso del audio recopilado en la naturaleza, en lugar de limitarlo a recopilarlo en el laboratorio, lo que requiere más tiempo”.

La investigación indica que el audio podría convertirse en una fuente de datos más solicitada en la carrera por entrenar robots con IA. Los investigadores están enseñando a los robots más rápido que nunca utilizando el aprendizaje por imitación, mostrándoles cientos de ejemplos de tareas que se están realizando en lugar de codificar manualmente cada tarea. Si el audio pudiera recopilarse a gran escala utilizando dispositivos como el del estudio, podría proporcionar un “sentido” completamente nuevo a los robots, ayudándolos a adaptarse más rápidamente a entornos donde la visibilidad es limitada o no es útil.

“Se puede decir con seguridad que el audio es la modalidad de detección menos estudiada” en robots, dice Dmitry Berenson, profesor asociado de robótica en la Universidad de Michigan, que no participó en el estudio. Esto se debe a que la mayor parte de la investigación robótica sobre manipulación de objetos se ha centrado en tareas industriales de recogida y colocación, como la clasificación de objetos en contenedores. Esas tareas no se benefician mucho del sonido, ya que dependen en cambio de sensores táctiles o visuales. Pero, a medida que los robots se amplíen a tareas en hogares, cocinas y otros entornos, el audio será cada vez más útil, dice Berenson.

Imaginemos un robot que intenta encontrar en qué bolso hay un juego de llaves, todo ello con visibilidad limitada. “Quizás incluso antes de tocar las llaves, las oigas como si tintinearan”, dice Berenson. “Esa es una señal de que las llaves están en ese bolsillo, en lugar de en otros”.

Sin embargo, el audio tiene límites. El equipo señala que el sonido no será tan útil con los llamados objetos blandos o flexibles, como la ropa, que no crean tanto audio utilizable. Los robots también tuvieron dificultades para filtrar el audio de sus propios ruidos motores durante las tareas, ya que ese ruido no estaba presente en los datos de entrenamiento producidos por humanos. Para solucionarlo, los investigadores tuvieron que agregar sonidos de robots (zumbidos, zumbidos y ruidos de actuadores) a los conjuntos de entrenamiento para que los robots pudieran aprender a ignorarlos.

El siguiente paso, dice Liu, es ver cuánto pueden mejorar los modelos con más datos, lo que podría significar más micrófonos, recopilación de audio espacial y agregar micrófonos a otros tipos de dispositivos de recopilación de datos.