En el caso de AI Overviews que recomienda una receta de pizza que contiene pegamento (basada en una publicación de broma de Reddit), es probable que la publicación pareciera relevante para la consulta original del usuario acerca de que el queso no se pega a la pizza, pero que algo salió mal en el proceso de recuperación. , dice Shah. “El hecho de que sea relevante no significa que sea correcto, y la parte generacional del proceso no lo cuestiona”, afirma.

De manera similar, si un sistema RAG encuentra información contradictoria, como un manual de políticas y una versión actualizada del mismo manual, no puede determinar de qué versión obtener su respuesta. En cambio, puede combinar información de ambos para crear una respuesta potencialmente engañosa.

“El modelo de lenguaje grande genera un lenguaje fluido basado en las fuentes proporcionadas, pero un lenguaje fluido no es lo mismo que información correcta”, dice Suzan Verberne, profesora de la Universidad de Leiden que se especializa en procesamiento del lenguaje natural.

Cuanto más específico es un tema, mayores son las posibilidades de que haya información errónea en la salida de un modelo de lenguaje grande, afirma, y añade: “Este es un problema en el ámbito médico, pero también en la educación y la ciencia”.

Según el portavoz de Google, en muchos casos, cuando AI Overviews arroja respuestas incorrectas es porque no hay mucha información de alta calidad disponible en la web para mostrar para la consulta, o porque la consulta coincide más estrechamente con sitios satíricos o publicaciones de broma.

La gran mayoría de las descripciones generales de IA proporcionan información de alta calidad, y muchos de los ejemplos de malas respuestas de las descripciones generales de IA fueron en respuesta a consultas poco comunes, dicen, y agregan que la cantidad de descripciones generales de IA que contienen contenido potencialmente dañino, obsceno o infractor representó menos de una de cada 7 millones de consultas únicas. Google continúa eliminando descripciones generales de IA en determinadas consultas de acuerdo con sus políticas de contenido.

No se trata sólo de malos datos de entrenamiento

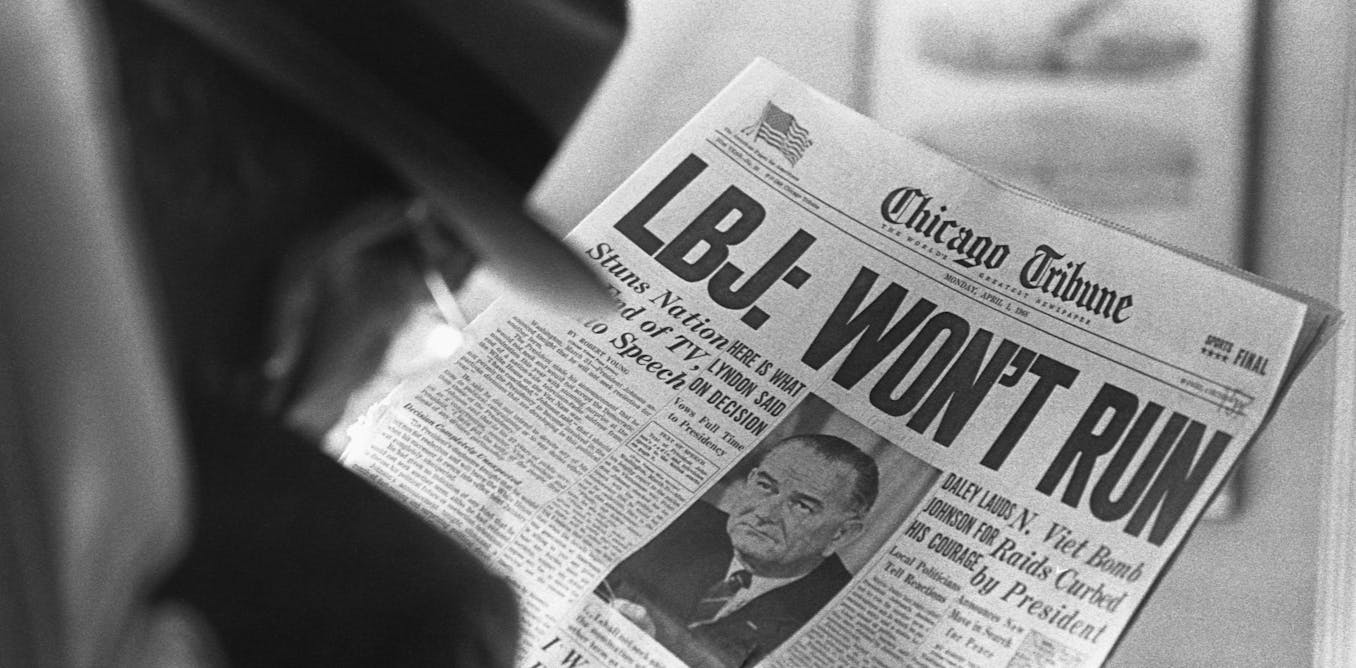

Aunque el error del pegamento para pizza es un buen ejemplo de AI Overviews que apunta a una fuente no confiable, AI Overviews aún puede generar información errónea a partir de fuentes objetivamente correctas. Melanie Mitchell, investigadora de inteligencia artificial en el Instituto Santa Fe en Nuevo México, buscó en Google “¿Cuántos presidentes musulmanes ha tenido Estados Unidos?”, a lo que AI Overviews respondió: “Estados Unidos ha tenido un presidente musulmán, Barack Hussein Obama”.

Si bien el propio Barack Obama no es musulmán, lo que hace que la respuesta de AI Overviews sea errónea, extrajo su información de un capítulo de un libro académico titulado Barack Hussein Obama: ¿el primer presidente musulmán de Estados Unidos? Así que el sistema de inteligencia artificial no sólo perdió todo el sentido del ensayo, sino que lo interpretó exactamente de manera opuesta, dice Mitchell. “Aquí hay algunos problemas para la IA; uno es encontrar una buena fuente que no sea una broma, pero otro es interpretar correctamente lo que dice la fuente”, añade. “Esto es algo que los sistemas de IA tienen problemas para hacer, y es importante tener en cuenta que incluso cuando obtienen una buena fuente, aún pueden cometer errores”.