El informe de amenazas adversas de OpenAI debería ser el preludio de un intercambio de datos más sólido en el futuro. En lo que respecta a la IA, investigadores independientes han comenzado a reunir bases de datos de uso indebido, como la base de datos de incidentes de IA y la base de datos de incidentes políticos deepfakes, para permitir a los investigadores comparar diferentes tipos de uso indebido y rastrear cómo el uso indebido cambia con el tiempo. Pero a menudo resulta difícil detectar el uso indebido desde el exterior. A medida que las herramientas de IA se vuelven más capaces y omnipresentes, es importante que los formuladores de políticas que consideran la regulación comprendan cómo se utilizan y abusan de ellas. Si bien el primer informe de OpenAI ofreció resúmenes de alto nivel y ejemplos seleccionados, ampliar las relaciones de intercambio de datos con investigadores que brinden más visibilidad sobre el contenido o los comportamientos conflictivos es un siguiente paso importante.

Cuando se trata de combatir las operaciones de influencia y el uso indebido de la IA, los usuarios en línea también tienen un papel que desempeñar. Después de todo, este contenido tiene un impacto sólo si las personas lo ven, lo creen y participan para compartirlo más. En uno de los casos revelados por OpenAI, los usuarios en línea denunciaron cuentas falsas que utilizaban texto generado por IA.

En nuestra propia investigación, hemos visto comunidades de usuarios de Facebook denunciar proactivamente contenido de imágenes generado por IA creado por spammers y estafadores, ayudando a aquellos que son menos conscientes de la tecnología a evitar ser víctimas del engaño. Una buena dosis de escepticismo es cada vez más útil: hacer una pausa para comprobar si el contenido es serious y si las personas son quienes dicen ser, y ayudar a amigos y familiares a ser más conscientes de la creciente prevalencia del contenido generado, puede ayudar a los usuarios de las redes sociales a resistir el engaño de propagandistas y estafadores por igual.

La publicación del site de OpenAI que anuncia el informe de eliminación lo expresó de manera sucinta: “Los actores de amenazas trabajan a través de Net”. Nosotros también debemos hacerlo. A medida que avanzamos hacia una nueva era de operaciones de influencia impulsadas por la IA, debemos abordar desafíos compartidos mediante la transparencia, el intercambio de datos y la vigilancia colaborativa si esperamos desarrollar un ecosistema digital más resiliente.

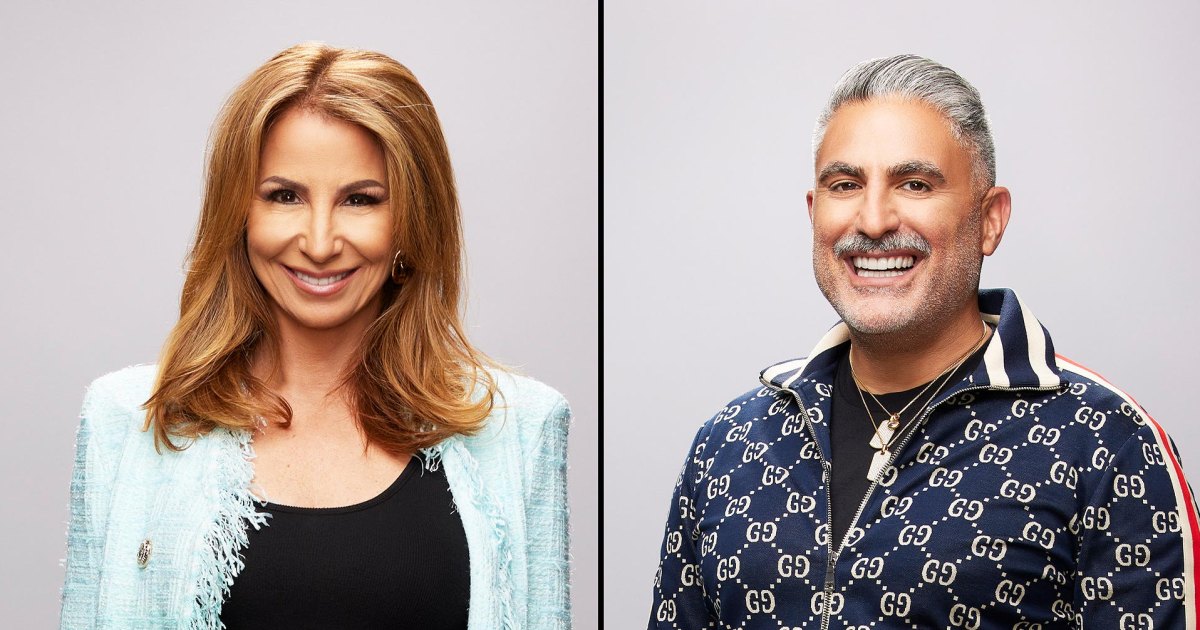

Josh A. Goldstein es investigador en el Centro de Seguridad y Tecnología Emergente (CSET) de la Universidad de Georgetown, donde trabaja en el Proyecto CyberAI. Renée DiResta es el director de investigación del Observatorio de Internet de Stanford y autor de Gobernantes invisibles: las personas que convierten las mentiras en realidad.