La teoría de la mente es un sello distintivo de la inteligencia emocional y social que nos permite inferir las intenciones de las personas y relacionarnos y empatizar unos con otros. La mayoría de los niños adquieren este tipo de habilidades entre los tres y cinco años de edad.

Los investigadores probaron dos familias de grandes modelos de lenguaje, GPT-3.5 y GPT-4 de OpenAI y tres versiones de Meta’s Llama, en tareas diseñadas para probar la teoría de la mente en humanos, incluida la identificación de creencias falsas, el reconocimiento de pasos en falso y la comprensión de lo que es. estar implícito en lugar de decirse directamente. También probaron a 1.907 participantes humanos para comparar los conjuntos de puntuaciones.

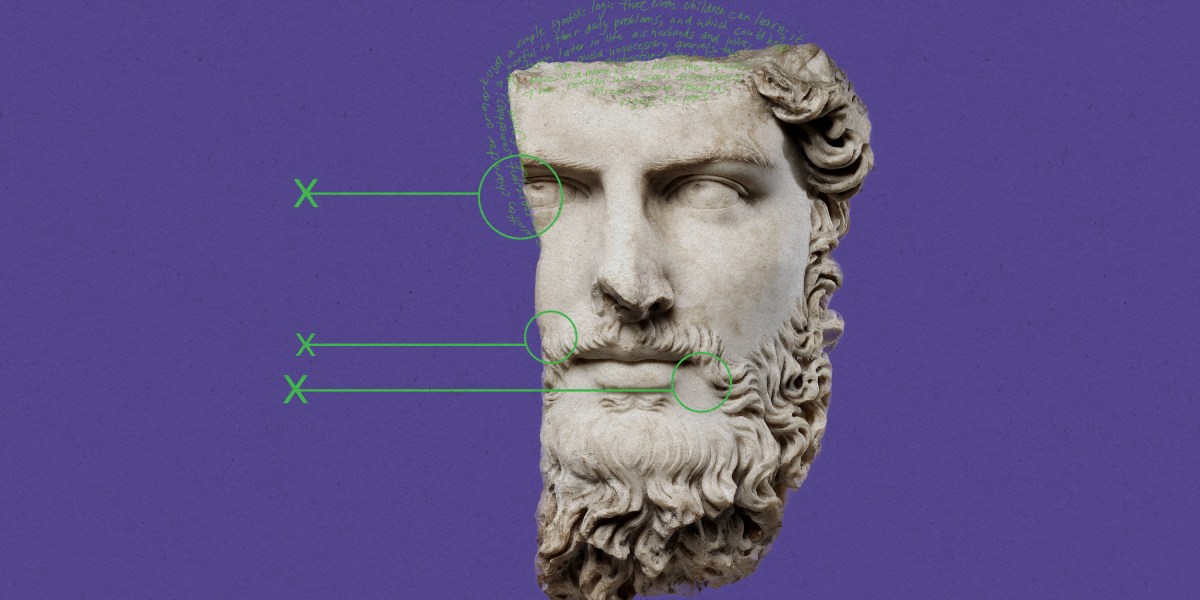

El equipo realizó cinco tipos de pruebas. La primera, la tarea de dar pistas, está diseñada para medir la capacidad de alguien para inferir las verdaderas intenciones de otra persona a través de comentarios indirectos. La segunda, la tarea de creencia falsa, evalúa si alguien puede inferir que se podría esperar razonablemente que otra persona crea algo que sabe que no es así. Otra prueba midió la capacidad de reconocer cuando alguien está cometiendo un paso en falso, mientras que una cuarta prueba consistió en contar historias extrañas, en las que un protagonista hace algo inusual, para evaluar si alguien puede explicar el contraste entre lo dicho y lo dicho. quiso decir. También incluyeron una prueba para determinar si las personas pueden comprender la ironía.

A los modelos de IA se les realizó cada prueba 15 veces en chats separados, para que trataran cada solicitud de forma independiente, y sus respuestas se calificaron de la misma manera que se united states of america para los humanos. Luego, los investigadores probaron a los voluntarios humanos y compararon los dos conjuntos de puntuaciones.

Ambas versiones de GPT se desempeñaron a la altura o, a veces, por encima de los promedios humanos en tareas que involucraban solicitudes indirectas, desvíos y creencias falsas, mientras que GPT-4 superó a los humanos en las pruebas de ironía, insinuaciones e historias extrañas. Los tres modelos de Llama 2 tuvieron un rendimiento inferior al promedio humano.

Sin embargo, Llama 2, el más grande de los tres metamodelos probados, superó a los humanos en lo que respecta a reconocer escenarios de pasos en falso, mientras que GPT proporcionó constantemente respuestas incorrectas. Los autores creen que esto se debe a la aversión standard de GPT a generar conclusiones sobre opiniones, porque los modelos respondieron en gran medida que no había suficiente información para responder de una forma u otra.