Esta confianza puede condicionar nuestro comportamiento. Normalmente, la gente tiende a suponer que los demás dicen la verdad. Esto se confirmó en este estudio: aunque los voluntarios sabían que la mitad de las afirmaciones eran mentiras, solo señalaron como tales el 19 % de ellas. Pero eso cambió cuando las personas decidieron utilizar la herramienta de inteligencia artificial: la tasa de acusaciones aumentó al 58 %.

En cierto modo, esto es algo bueno: estas herramientas pueden ayudarnos a detectar más mentiras que encontramos en nuestras vidas, como la información errónea que podemos encontrar en las redes sociales.

Pero no todo es bueno. También podría socavar la confianza, un aspecto essential del comportamiento humano que nos ayuda a establecer relaciones. Si el precio de tomar decisiones acertadas es el deterioro de los vínculos sociales, ¿vale la pena?

Y luego está la cuestión de la precisión. En su estudio, von Schenk y sus colegas sólo estaban interesados en crear una herramienta que fuera Mejor que los humanos En la detección de mentiras, algo que no resulta demasiado difícil, teniendo en cuenta lo mal que lo hacemos. Pero también imagina que una herramienta como la suya se utilice para evaluar de forma rutinaria la veracidad de las publicaciones en las redes sociales o para buscar detalles falsos en el currículum o las respuestas de una entrevista de trabajo. En casos como estos, no basta con que una tecnología sea “mejor que los humanos” si va a hacer más acusaciones.

¿Estaríamos dispuestos a aceptar una tasa de precisión del 80%, donde sólo cuatro de cada cinco afirmaciones evaluadas serían interpretadas correctamente como verdaderas o falsas? ¿Bastaría con una precisión del 99%? No estoy seguro.

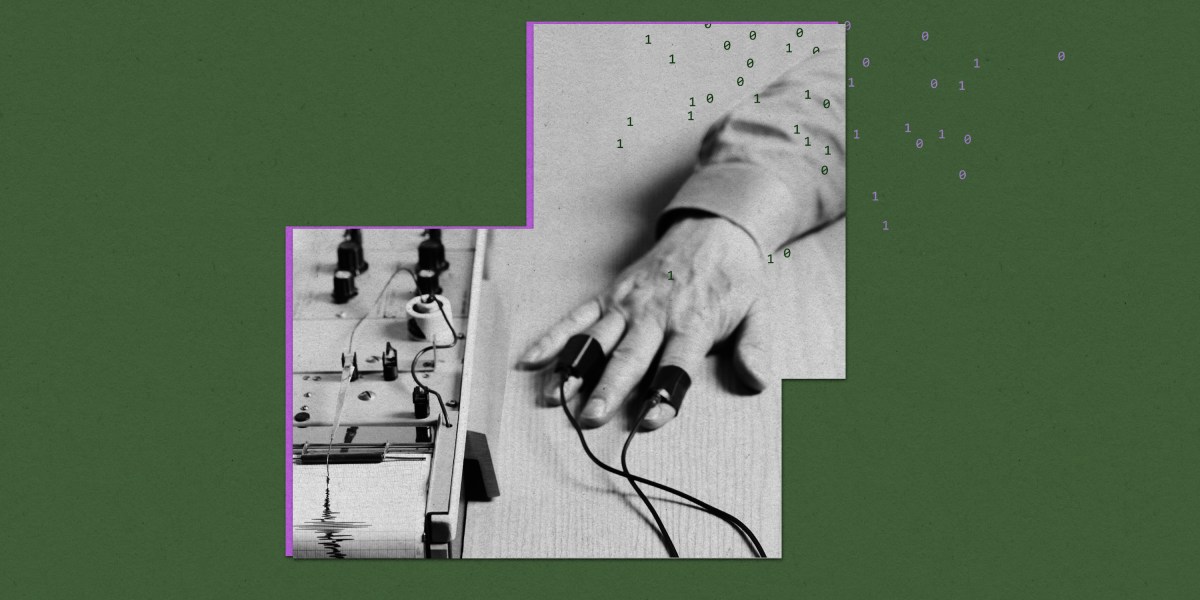

Vale la pena recordar la falibilidad de las técnicas históricas de detección de mentiras. El polígrafo fue diseñado para medir la frecuencia cardíaca y otros signos de “excitación” porque se creía que algunos signos de estrés eran exclusivos de los mentirosos. No es así. Y lo sabemos desde hace mucho tiempo. Por eso, los resultados del detector de mentiras generalmente no son admisibles en los casos judiciales de los EE. UU. A pesar de eso, las pruebas del detector de mentiras del polígrafo han perdurado en algunos entornos y han causado mucho daño cuando se han utilizado para lanzar acusaciones a personas que no las superan en programas de telerrealidad.

Las herramientas de IA imperfectas pueden tener un impacto aún mayor porque son muy fáciles de escalar, afirma von Schenk. Solo se puede aplicar el polígrafo a una determinada cantidad de personas al día. En comparación, el alcance de la detección de mentiras por inteligencia artificial es casi ilimitado.

“Dado que hay tantas noticias falsas y desinformación difundiéndose, estas tecnologías tienen sus ventajas”, afirma von Schenk. “Sin embargo, es necesario ponerlas a prueba, hay que asegurarse de que sean sustancialmente mejores que los humanos”. Si un detector de mentiras de IA genera muchas acusaciones, quizá sea mejor no usarlo en absoluto, afirma.

Ahora lee el resto de El Chequeo

Lea más del archivo de MIT Technologies Assessment

También se han desarrollado detectores de mentiras de inteligencia artificial para buscar patrones faciales de movimiento y “microgestos” asociados con el engaño. Como dice Jake Bittle: “El sueño de un detector de mentiras perfecto no morirá, especialmente cuando se lo oculte con el brillo de la IA”.

Por otro lado, la IA también se utiliza para generar mucha desinformación. En octubre del año pasado, la IA generativa ya se utilizaba en al menos 16 países para “sembrar dudas, desprestigiar a los oponentes o influir en el discussion público”, como informó Tate Ryan-Mosley.

La forma en que se desarrollan los modelos de lenguaje de IA puede influir en gran medida en la forma en que funcionan. Como resultado, estos modelos han adoptado diferentes sesgos políticos, como señaló mi colega Melissa Heikkilä el año pasado.

La IA, al igual que las redes sociales, tiene potencial para hacer el bien o el mal. En ambos casos, los límites regulatorios que impongamos a estas tecnologías determinarán hacia dónde caiga la espada, argumentan Nathan E. Sanders y Bruce Schneier.

Las respuestas del chatbot son todas inventadas. Pero existe una herramienta que puede otorgar una puntuación de confiabilidad a los resultados de modelos de lenguaje de gran tamaño, lo que ayuda a los usuarios a determinar cuán confiables son. O, como lo expresó Will Douglas Heaven en un artículo publicado hace unos meses, un medidor de mentiras para los chatbots.

De toda la net

Científicos, especialistas en ética y expertos legales del Reino Unido han publicado un nuevo conjunto de directrices para la investigación con embriones sintéticos o, como los llaman, “modelos de embriones basados en células madre (SCBEM)”. La directriz establece que debería haber límites en cuanto al tiempo durante el cual se cultivan en laboratorios y que no deberían transferirse al útero de un ser humano o un animal. También señala que, si en el futuro parece que estas estructuras podrían tener el potencial de convertirse en un feto, deberíamos dejar de llamarlas “modelos” y, en su lugar, referirnos a ellas como “embriones”.

La resistencia a los antimicrobianos ya es responsable de 700.000 muertes cada año y podría costarle la vida a 10 millones de personas al año en 2050El uso excesivo de antibióticos de amplio espectro es en parte responsable. ¿Ha llegado el momento de gravar estos medicamentos para limitar la demanda? (Revista Internacional de Organización Industrial)

Los vuelos espaciales pueden alterar el cerebro humano, reorganizando la materia gris y blanca y provocando que el cerebro se desplace hacia arriba en el cráneo. Necesitamos comprender mejor estos efectos y el impacto de la radiación cósmica en nuestros cerebros antes de enviar personas a Marte. (The Lancet Neurology)

El nervio vago se ha convertido en una estrella inesperada de las redes sociales, gracias a personas influyentes que promocionan los beneficios de estimularlo. Lamentablemente, la ciencia no se sostiene. (New Scientist)

Un healthcare facility de Texas se convertirá en el primero del país en permitir a los médicos ver a sus pacientes a través de un holograma. El Hospital Regional Crescent de Lancaster ha instalado Holobox, un sistema que proyecta un holograma de tamaño real de un médico para consultas con pacientes. (ABC Information)