Teodor Grantcharov, profesor de cirugía en Stanford, cree haber encontrado una herramienta para hacer la cirugía más segura y minimizar el error humano: “cajas negras” impulsadas por IA en quirófanos que funcionan de manera equivalent a la caja negra de un avión. Estos dispositivos, construidos por la empresa Surgical Security Systems de Grantcharov, registran todo lo que ocurre en el quirófano mediante cámaras panorámicas, micrófonos en el techo y monitores de anestesia antes de utilizar inteligencia synthetic para ayudar a los cirujanos a entender los datos. Captan todo el quirófano en su conjunto, desde el número de veces que se abre la puerta hasta cuántas conversaciones no relacionadas con un caso se producen durante una operación.

Estas cajas negras se utilizan en casi 40 instituciones de Estados Unidos, Canadá y Europa occidental, desde Mount Sinai hasta Duke y la Clínica Mayo. Pero, ¿están los hospitales en la cúspide de una nueva era de seguridad o están creando un ambiente de confusión y paranoia? Lea la historia completa de Simar Bajaj aquí.

Esto me pareció una historia con implicaciones más amplias. Organizaciones de todos los sectores están pensando en cómo adoptar la IA para hacer las cosas más seguras y eficientes. Lo que muestra este ejemplo de hospitales es que la situación no siempre es clara y hay muchos obstáculos que es necesario evitar.

Aquí hay tres lecciones sobre la adopción de la IA que aprendí de esta historia:

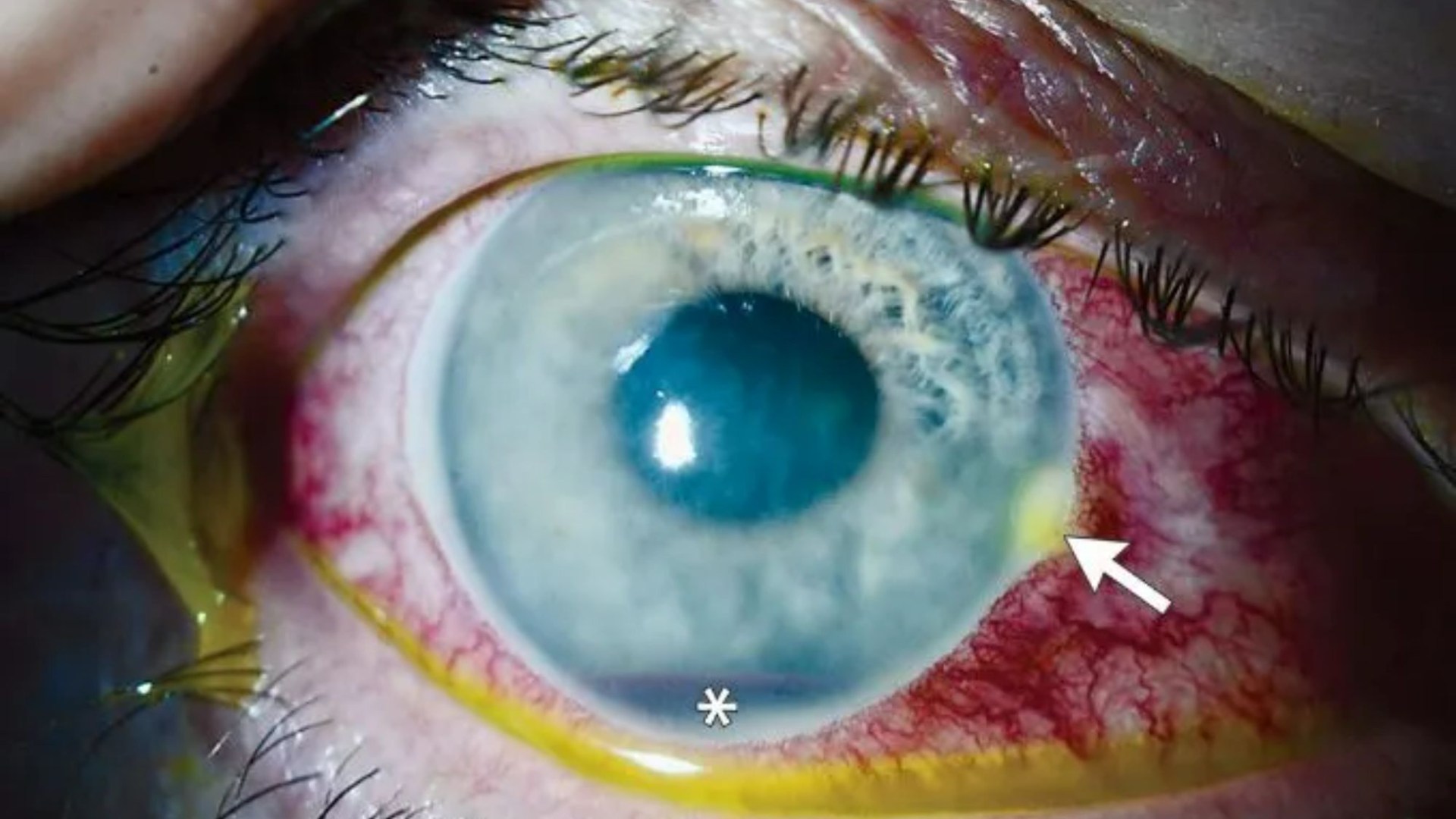

1. La privacidad es importante, pero no siempre está garantizada. Grantcharov se dio cuenta muy rápidamente de que la única manera de lograr que los cirujanos utilizaran la caja negra period hacerlos sentir protegidos de posibles repercusiones. Ha diseñado el sistema para registrar acciones pero ocultar las identidades tanto de los pacientes como del individual, incluso eliminando todas las grabaciones en un plazo de 30 días. Su concept es que ningún individuo debería ser castigado por cometer un error.

Las cajas negras hacen que cada persona en la grabación sea anónima un algoritmo distorsiona las voces de las personas y difumina sus rostros, transformándolos en figuras sombrías y de estilo noir. Entonces, incluso si sabes lo que pasó, no puedes usarlo contra un individuo.

Pero este proceso no es perfecto. Antes de que las grabaciones de hace 30 días se eliminen automáticamente, los administradores del healthcare facility aún pueden ver el número del quirófano, la hora de la operación y el número de historia clínica del paciente, por lo que incluso si el particular técnicamente no está identificado, no son verdaderamente anónimos. . El resultado es una sensación de que “el Gran Hermano está observando”, dice Christopher Mantyh, vicepresidente de operaciones clínicas del Hospital de la Universidad de Duke, que tiene cajas negras en siete quirófanos.

2. No se pueden adoptar nuevas tecnologías sin ganarse primero a la gente. La gente a menudo sospecha, con razón, de las nuevas herramientas, y las fallas del sistema en lo que respecta a la privacidad son parte de la razón por la que el own ha dudado en adoptarlo. Muchos médicos y enfermeras boicotearon activamente las nuevas herramientas de vigilancia. En un clinic, las cámaras fueron saboteadas al darles la vuelta o al desconectarlas deliberadamente. Algunos cirujanos y particular se negaron a trabajar en las salas donde se encontraban.